No início da década de 1930 o astrônomo suíço Fritz Zwicky estava usando um novo tipo de telescópio no topo do Monte Palomar, Califórnia, para fotografar grandes áreas do céu em tomadas rápidas e com pouca distorção. Ele construiu um grande mapa com centenas de milhares de galáxias, o Catálogo Zwicky de Galáxias. Fazendo isso ele e seus colegas descobriram que as galáxias tendem a se juntar em aglomerados. Estudando o Aglomerado de Galáxias de Coma, sob a luz das descobertas de Hubble, ele notou uma anomalia no movimentos das galáxias dentro de aglomerados.

De acordo com as leis de Newton objetos que se movem mais afastados do centro de massa a que estão ligados devem se mover mais lentamente. Este princípio se reflete em uma das leis de Kepler para o movimento dos planetas no sistema solar. No entanto Zwicky percebeu que mesmo as galáxias mais afastadas mantinham velocidades altas demais em relação à massa observada do aglomerado.

Fritz Zwicky (1898 — 1974) foi um astrônomo suíço que trabalhou a maior parte de sua vida nos EUA. Zwicky foi o primeiro astrónomo a usar o teorema do virial para fazer inferências sobre a existência da não-observada matéria escura, descrevendo-a como dunkle Materie (dark matter ou matéria escura). Ele foi também o primeiro a observar estrelas super brilhantes, que ele denominou supernovas, que se formam quando as estrelas estão em sua fase final de evolução, depois de usar a maior parte de seu combustível nuclear. Supernovas são a fonte de grande parte dos raios cósmicos que chegam a Terra e marcam a transição entre estrelas comuns e as estrelas de neutrons. Zwicky propôs a existência das lentes gravitacionais, uma consequência da teoria da gravitação de Einstein.

Fritz Zwicky (1898 — 1974) foi um astrônomo suíço que trabalhou a maior parte de sua vida nos EUA. Zwicky foi o primeiro astrónomo a usar o teorema do virial para fazer inferências sobre a existência da não-observada matéria escura, descrevendo-a como dunkle Materie (dark matter ou matéria escura). Ele foi também o primeiro a observar estrelas super brilhantes, que ele denominou supernovas, que se formam quando as estrelas estão em sua fase final de evolução, depois de usar a maior parte de seu combustível nuclear. Supernovas são a fonte de grande parte dos raios cósmicos que chegam a Terra e marcam a transição entre estrelas comuns e as estrelas de neutrons. Zwicky propôs a existência das lentes gravitacionais, uma consequência da teoria da gravitação de Einstein.

Mais especificamente, Zicky aplicou o Teorema do Virial que relaciona a energia potencial gravitacional com o movimento das partes de um sistema. Nas velocidades observadas as galáxias deveriam romper com a atração gravitacional exercida pelo grupo e partir em voo livre pelo espaço. Em resumo, a massa do aglomerado, deduzida à partir da observação da luz por elas emitidas, era insuficiente para explicar por que as galáxias mais afastadas do centro permaneciam ligadas ao aglomerado.

Para resolver esta anomalia Zwicky apresentou a hipótese de que grande parte da massa no aglomerado era constituída por um novo tipo de matéria, que já havia sido cogitado por outros astrônomos, denominado Dark Matter ou matéria escura. Esta matéria deveria ser diferente da usual, exercendo atração gravitacional sobre outros corpos mas não interagindo com eles de nenhuma outra forma. Naturalmente, dada a exoticidade da sugestão, algum tempo se passou até que outras evidências foram encontradas para dar suporte à hipótese e a matéria escura fosse amplamente aceita pelas astrônomos e cosmólogos.

Em 1965 a astrofísica americana Vera Rubin estava trabalhando com amplificadores eletrônicos de luz que permitiam a coleta rápida de espectros de emissão de galáxias. Ela estudava a rotação de galáxias como Andrômeda, nossa vizinha, e descobriu coisas interessantes e inesperadas. Com esses aparelhos sensíveis ela obteve as curvas de rotação para objetos dentro da galáxia.

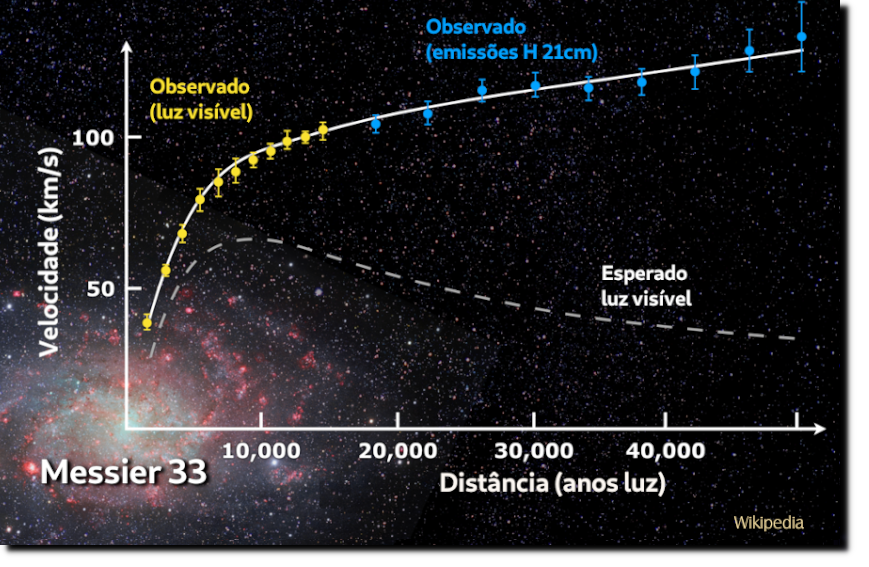

Galáxias espirais possuem longos braços que giram em torno do centro galático. A densidade de massa luminosa decai quando de afasta do centro em direção às bordas. Estrelas (e outros objetos) mais afastadas deveriam ter velocidades cada vez menores, de acordo com a segunda lei de Kepler, da mesma forma que acontece com os planetas no sistema solar. Mas, como observou Rubin, isso não ocorre. Surpreendentemente as velocidades ficam quase inalteradas com o distanciamento do centro. Esse efeito pode ser explicado postulando a existência de um halo, algo como uma bola oca gigante envolvendo a galáxia, feito de algum material com atração gravitacional. O problema está em que esse halo não aparece nas fotos dos telescópios nem nas imagens geradas pelos radiotelescópios.

Intrigados com a observação, Rubin e vários outros pesquisadores começaram a coletar dados sobre outras galáxias e, em todos os casos, o mesmo fenômeno foi verificado. Mais uma vez se levantou a hipóteses de que existe um agente de atração não detectado dentro do conjunto estudado. Rubin estimou que deveria existir em torno de 6 vezes mais massa do que a observada por meios luminosos.

Hoje pelo menos três tipos de observações independentes confirmam a existência da matéria escura. A velocidade das galáxias em aglomerados ou de estrelas dentro das galáxias, a emissão de raios-X pelo gases que permeiam os aglomerados e as lentes gravitacionais. Por todos esses meios se constata que em torno de 80% da massa dos aglomerados, em média, é formada por um tipo de matéria exótica que não emite luz nem nenhuma outra forma de radiação eletromagnética detectável.

Lentes Gravitacionais

De acordo com a Teoria da Relatividade Geral (TRG) de Einstein a presença da matéria deforma o espaço em torno dela. Um feixe de luz, emitido por uma estrela distante, passando perto do Sol, por exemplo, se desvia fazendo com que a estrela pareça estar em outro ponto no céu. Esse efeito foi usado em 1919, Sobral, nordeste do Brasil, para prover a primeira verificação observacional da TRG. Aproveitando-se de um eclipse solar astrônomos ingleses puderam mostrar que o desvio da luz era compatível com aquele previsto na teoria de Einstein.

Zwicky já havia proposto que seria possível usar um aglomerado de matéria no espaço como lente gravitacional, uma vez que o espaço deforma a luz que foi emitida por trás. Essas lentes são observadas através de efeitos peculiares, tais como a formação de imagens múltiplas de um mesmo objeto ou arcos e anéis formados por deformação da imagem. Através das medidas de distorção é possível se calcular a massa da lente, o objeto que causou essa distorção. Desta forma é possível confirmar que existe uma deformação maior do que aquela que seria causada apenas pelos objetos luminosos, o que vem a fortalecer a hipótese de que existe matéria escura presente nesse objeto.

Evidência Cosmológica

Cosmologia, a Estrutura do Universo

Outra indicação importante de que a matéria escura realmente existe é dada pela cosmologia. A Teoria do Big Bang, a mais amplamente aceita na atualidade, é uma aplicação direta da TRG sob a hipótese de que o universo é bastante uniforme, em grandes escalas. Dependendo da densidade de massa nesse modelo a geometria universal assume uma das três formas possíveis de espaços homogêneos (igual em todos os pontos) e isotrópicos (igual em todas as direções). Se a densidade de massa no universo (massa dividida pelo volume) for acima de um certo número crítico o universo seria formado por seções esféricas (ou seja, a cada momento ele seria uma hiper-esfera de 3 dimensões, de curvatura positiva). Se a densidade for abaixo do número crítico o universo teria seções como selas (de curvatura negativa). Mas a observação não mostra curvatura mensurável indicando que estamos exatamente sobre o caso crítico de um universo com densidade tal que o espaço contém seções planas, de curvatura nula. No entanto a massa visível, observada em estrelas e galáxias e todos os demais corpos luminosos, é bem inferior a essa massa crítica, o que leva a crer, mais uma vez, que grande parte dela está sob a forma de matéria escura.

Outra consequência observada do Big Bang é a chamada radiação cósmica de fundo, um resíduo deixado pela radiação inicial de alta temperatura. Com a expansão essa radiação se encontra hoje muito mais fria, aproximadamente de 3ºC, com vibração na faixa de micro-ondas. Ela pode ser mapeada com precisão, sendo uniforme o bastante para embasar o modelo cosmológico padrão, mas possuindo granulação suficiente para a geração das estruturas formadas mais tarde, como galáxias, aglomerados e filamentos. A matéria escura e a ordinária não se comportam da mesma forma com a expansão do espaço. Embora as duas interajam gravitacionalmente, a matéria bariônica (ordinária) passou por um período de interação forte com a radiação nos momentos primordiais da evolução. Essas interações alteram a forma como a granulação inicial evoluiu mais tarde formando estruturas. A observação do universo hoje, comparado com as granulações da radiação de fundo, corrobora a hipótese de que grande porção da massa hoje existente é formada por matéria escura.

Boa parte da pesquisa moderna em astronomia se concentra na busca dessa matéria e sua natureza permanece em debate. Inicialmente se considerava que essa matéria fosse formada por estrelas frias e pouco brilhantes, por planetas escuros e errantes, por gases ou por corpos macroscópicos ou não, espalhados no meio intergalático. Houve a sugestão de que buracos negros poderiam ser abundantes a ponto de fornecer essa massa oculta. Mas, se esse fosse o caso, os atuais buracos negros seriam feitos de matéria ordinária antes que estas estrelas colapsassem. Toda essa matéria ordinária estaria presente nos primeiros momentos do universo, o que estaria em discordância com a quantidade de matéria escura esperada pela análise da radiação cósmica de fundo.

Teoricamente um tipo diferente de buraco negro pode existir e estas entidades hipotéticas foram consideradas como partes de matéria escura. Buracos negros primordiais podem ter sido criados no início do universo quando a própria matéria comum estava se formando. Eles poderiam ter se originado de flutuações do espaço-tempo logo após o Big Bang, fortes o bastante para aglomerar blocos de massa em um volume muito pequeno, formando buracos negros diminutos. A modelagem computacional sugere que eles poderiam ter massas bem pequenas e poderiam ser responsáveis por parte do efeito atribuído à matéria escura. Em 2018 foi realizada uma pesquisa em 740 supernovas em busca de efeitos de lentes gravitacionais causadas por esses objetos e o resultado indica que eles não podem explicar mais que 40% do efeito da matéria escura. Pelo contrário, surgiram indicações de que esta não é uma boa hipóteses e que buracos negros primordiais não contribuem nessa questão. Além disso não existem evidências de eles existam de fato.

Portanto a hipótese da matéria escura como constituída por matéria ordinária entra em conflito com o que é observado e nenhum dos modelos propostos foi capaz de explicar as anomalias observadas. A teoria mais aceita é a de que esta matéria é não bariônica, o que significa que não é composta de prótons e nêutrons como a matéria ordinária que conhecemos. A primeira possibilidade consiste em explorar os neutrinos.

Neutrinos

A existência dos neutrinos foi proposta em 1930, 26 anos anos de sua detecção experimental. Durante o decaimento beta a força nuclear fraca, dentro do núcleo atômico, quebra um nêutron em um próton mais um elétron, que é ejetado do átomo. Apesar de que a carga criada no próton (+) fica balanceada pelo elétron (-), Wolfgang Pauli notou que seria necessária a criação de outra partícula para equilibrar a energia, o momento linear e o momento angular do átomo inicial.

Curiosamente o neutrino foi proposto 2 anos antes da descoberta do nêutron, por James Chadwick. Neutrinos possuem massa, portanto tem efeito gravitacional, mas não interagem por meio da força eletromagnética.Neutrinos são difíceis de serem detectados.

Hoje, com o avanço da tecnologia, é possível saber se um neutrino foi emitido pelo Sol, por outros objetos no sistema solar ou na Via Láctea, ou mesmo por fontes fora de nossa galáxia.

Uma das hipóteses feitas para solucionar o mistério da matéria escura consiste em apelar para o Modelo Padrão de Partículas da física. Neste modelo, que é muito bem sucedido na explicação das partículas conhecidas, existem os neutrinos, partículas estáveis (de longa vida) que não interagem com outras partículas por meio do eletromagnetismo nem das interações nucleares fortes. Neutrinos atravessam grandes amontoados de matéria (como o planeta Terra, por exemplo) sem sofrer alterações. O modelo dos WIMPs (weakly interacting massive particles, partículas massivas de interação fraca) inicialmente considerou neutrinos formados no início do universo, deixados como resíduos da grande explosão inicial, como os responsáveis pela atração da matéria não luminosa.

Na década de 1980 as simulações numéricas realizadas em computador começaram a ganhar importância no estudo da evolução do universo e da formações de estruturas, como galáxias, aglomerados e grandes filamentos cósmicos. No modelo padrão é predito que os neutrinos foram formados com altíssimas velocidades, comparáveis (mas inferiores) à velocidade da luz. De acordo com as simulações estas partículas quentes (por que muito velozes) favoreceriam a formação inicial de estruturas muito grandes que apenas mais tarde se quebrariam em blocos menores, formando coisas tais como as galáxias.

Em contraste, partículas mais frias (lentas) estimulariam a formação de pequenos aglomerados de matéria, que bem mais tarde se fundiriam formando estruturas maiores. Comparando estes resultados teóricos com as estruturas observadas se descartou a predominância de neutrinos super velozes na composição da matéria escura. As simulações deixaram claro que pelo menos uma partícula desconhecida, não presente no modelo padrão de partículas, deveria existir.

Uma outra partícula proposta para explicar efeitos da matéria escura são os áxions, partículas ainda não detectadas, por enquanto apenas uma conjectura teórica proposta para resolver outro problema existente na cromodinâmica quântica. Se existirem eles interagiriam pouco com a matéria comum e radiação, teriam massa bem pequena. Eles poderiam, no entanto, existir em quantidade suficiente para explicar os efeitos da massa desaparecida.

Gravitação Alternativa

Em 1983 o astrofísico Mordehai Milgrom sugeriu um mecanismo alternativo para explicar as anomalias observadas nos movimentos galáticos. Ou invés de buscar fontes desconhecidas de atração gravitacional ele optou por sugerir alterações na teoria gravitacional. Sua hipótese foi denominada Dinâmica Newtoniana Modificada (Modified Newtonian Dynamics) ou MOND.

A gravitação Newtoniana está muito bem verificada na escala de experiência cotidiana, em experimentos feitos na Terra. Não há garantia absoluta de que ela continua funcionando da mesma forma em escalas galáticas. Assim como a Gravitação de Einstein se reduz à Newtoniana para a escala cotidiana, Milgrom propôs uma teoria alternativa que age um pouco diferente em grandes escalas.

Algumas galáxias parecem se movimentar em bom acordo com a teoria MOND mas ela não resolve todos os problemas. Resta, no entanto, explorar outros modelos, com novas descrições da gravitação, até que todas as anomalias fiquem bem explicadas.

Conclusão

A questão da natureza da matéria escura e da energia escura permanece em aberto, juntamente com muitos outros problemas importantes ainda não foram resolvidos pela ciência. Pela própria natureza da investigação científica cada resposta obtida abre um leque de dúvidas e caminhos para futuras pesquisas. O tema é de grande interesse porque, entre outras coisas, ele pode levar a uma expansão da física para novos domínios, da mesma forma que a mecânica quântica e a relatividade expandiram a física clássica. Se existem partículas fora do modelo padrão de partículas então uma nova física tem que ser desenvolvida para acomodá-las.

Novos detetores e novas táticas de busca são desenvolvidos a todo momento para tentar verificar ou descartar alguma hipótese. Em outubro de 2017 o Observatório LIGO conseguiu detetar ondas gravitacionais geradas pela interação de duas estrelas de nêutrons girando em órbitas muito próximas e espiralando para seu centro de massa. A observação dessas ondas abre uma nova página na investigação do cosmos e deverá ser usada também para testar hipóteses sobre a matéria escura, em particular a existência de buracos negros primordiais.

É possível que a anomalia observada (o problema da matéria escura) seja devida a erros nos pressupostos cosmológicos, sendo o principal deles considerar que o universo é uniforme, aproximadamente igual em todas as direções e em todas as partes. No estado atual do conhecimento é impossível descartar que nossa posição no universo seja de alguma forma incomum, nos dando uma falsa visão de como seria o todo. Também é possível que uma nova forma da interação gravitacional seja válida para escalas cósmicas, ou que existam forças desconhecidas, além das quatro forças fundamentais. Também devemos nos lembrar que os dados obtidos nessa área são difíceis de se obter e analisar. Mesmo assim grande parte dos cosmólogos e astrofísicos defende que existe a matéria escura. Aqueles que acreditam em coisas diferentes estão propondo teorias alternativas, nenhuma delas ainda com sucesso.

A própria existência de um problema tão importante sem solução até o momento torna a pesquisa ainda mais interessante. A ciência é uma aventura com desdobramentos inesperados. Pessoas no mundo inteiro se unem e trabalham na solução desses problemas. Infelizmente, o processo científico se torna cada vez mais especializado e inacessível para pessoas sem treinamento específico. Para isso servem artigos (como este) e livros de divulgação. A aventura é coletiva e deve ser partilhada com todos.

Bibliografia

Clegg, Brian: Dark Matter & Dark Energy, Icon Books, Agosto 2019.

Bertone, Gianfranco; Hooper, Dan: A History of Dark Matter https://arxiv.org/abs/1605.04909 (16 May 2016).

Panek, Richard: The 4% Universe, Dark Matter, Dark Energy, and The Race to Discover the Rest of Reality, HMH Books & Media, New York, 2011.

Science History: Fritz Zwicky and the whole Dark Matter thing

https://cosmosmagazine.com/physics/science-history-fritz-zwicky-and-the-whole-dark-matter-thing